La macchina che agisce freddamente

DA LA FIONDA (Di Redazione)

Come redazione abbiamo deciso di tradurre un’importante inchiesta del Guardian a firma di Bethany McKernan e Harry Davis, i quali tornano sull’argomento già affrontato da uno dei nostri articoli. Da un lato l’uso della AI e il processo di agghiacciante disumanizzazione per quanto riguarda le tecniche di guerra è un segno dei nostri tempi. Ma resta altrettanto attuale la domanda: se tali modalità di annientamento fossero usate contro le popolazioni europee e occidentali cosa diremmo? Forse anche il fatto di considerare, più o meno inconsapevolmente, taluni gruppi come vittime predestinate a subire tali diaboliche sperimentazioni militari è un segno tragico del tempo che ci è dato vivere.

Fonti dell’intelligence israeliana rivelano l’uso del sistema “Lavender” nella guerra di Gaza e rivendicano il permesso dato di uccidere civili nell’inseguimento di militanti di basso rango

Secondo fonti di intelligence coinvolte nella guerra, la campagna di bombardamenti dell’esercito israeliano a Gaza ha utilizzato un database precedentemente segreto basato sull’intelligenza artificiale che ha identificato 37.000 potenziali obiettivi in base ai loro apparenti collegamenti con Hamas.

Oltre a parlare dell’uso del sistema di intelligenza artificiale, chiamato Lavender, le fonti dell’intelligence affermano che i funzionari militari israeliani hanno permesso che un gran numero di civili palestinesi venissero uccisi, in particolare durante le prime settimane e i primi mesi del conflitto .

La loro testimonianza insolitamente schietta fornisce uno sguardo raro sulle esperienze di prima mano dei funzionari dell’intelligence israeliana che hanno utilizzato sistemi di apprendimento automatico per identificare gli obiettivi durante i sei mesi di guerra.

L’uso da parte di Israele di potenti sistemi di intelligenza artificiale nella sua guerra contro Hamas è entrato in un territorio inesplorato per il warfare più avanzato, sollevando una serie di questioni legali e morali e trasformando il rapporto tra personale militare e macchine.

“Questo non ha prevedenti, a mia memoria”, ha detto un ufficiale dell’intelligence che ha utilizzato Lavender, aggiungendo che avevano più fiducia in un “meccanismo statistico” che in un soldato in lutto. “Tutti lì, me compreso, hanno perso delle persone il 7 ottobre. La macchina ha agito con freddezza. E questo ha reso tutto più semplice”.

Un altro utilizzatore di Lavender si è chiesto se il ruolo degli esseri umani nel processo di selezione fosse significativo. “Investirei 20 secondi per ciascun obiettivo in questa fase e ne farei dozzine ogni giorno. Come essere umano non avevo alcun valore aggiunto, a parte essere un segno di approvazione. Ha risparmiato molto tempo.”

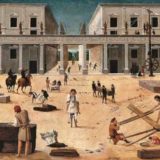

Visualizza l’immagine a schermo intero

Bambini palestinesi recuperano oggetti in mezzo alla distruzione causata dai bombardamenti israeliani a Bureij, nel centro di Gaza, il 14 marzo. Fotografia: AFP/Getty Images

La testimonianza dei sei ufficiali dell’intelligence, tutti coinvolti nell’utilizzo di sistemi di intelligenza artificiale per identificare gli obiettivi di Hamas e della Jihad islamica palestinese (PIJ) nella guerra, è stata fornita al giornalista Yuval Abraham per un rapporto pubblicato dalla pubblicazione israelo-palestinese + 972 Magazine e la piattaforma in ebraico Local Call .

I loro resoconti sono stati condivisi esclusivamente con il Guardian prima della pubblicazione. Tutti e sei affermarono che Lavender aveva svolto un ruolo centrale nella guerra, elaborando masse di dati per identificare rapidamente potenziali agenti “giovani” da prendere di mira. Quattro delle fonti hanno affermato che, in una fase iniziale della guerra, Lavender ha elencato ben 37.000 uomini palestinesi che erano stati collegati dal sistema AI a Hamas o PIJ.

Lavender è stata sviluppata dalla divisione di intelligence d’élite delle forze di difesa israeliane, l’Unità 8200, che è paragonabile alla National Security Agency degli Stati Uniti o al GCHQ nel Regno Unito.

Molte fonti hanno descritto come, per alcune categorie di obiettivi, l’IDF abbia applicato quote pre-autorizzate per il numero stimato di civili che potrebbero essere uccisi prima che un attacco fosse autorizzato.

Due fonti hanno affermato che durante le prime settimane di guerra è stato permesso loro di uccidere 15 o 20 civili durante attacchi aerei contro militanti di basso rango. Gli attacchi contro tali obiettivi venivano generalmente effettuati utilizzando munizioni non guidate note come “bombe stupide”, hanno detto le fonti, distruggendo intere case e uccidendo tutti i loro occupanti.

“Non devi sprecare bombe costose su persone non importanti: è molto costoso per il paese e c’è carenza [di quelle bombe]”, ha detto un ufficiale dell’intelligence. Un altro ha affermato che la domanda principale da affrontare era se i “danni collaterali” ai civili consentissero un attacco.

“Perché di solito sferravamo gli attacchi con bombe stupide, e questo significava letteralmente far cadere l’intera casa sui suoi occupanti. Ma anche se l’attacco viene sventato, non ti interessa: passi subito al bersaglio successivo. A causa del sistema, gli obiettivi non finiscono mai. Ne hai altri 36.000 in attesa.”

Secondo esperti di conflitti, il fatto che Israele abbia usato bombe stupide per radere al suolo le case di migliaia di palestinesi che erano ricondotti dalla AI a gruppi militanti a Gaza potrebbe aiutare a spiegare il numero incredibilmente alto di vittime della guerra.

Il ministero della Sanità nel territorio controllato da Hamas afferma che 33.000 palestinesi sono stati uccisi nel conflitto negli ultimi sei mesi. I dati delle Nazioni Unite mostrano che solo nel primo mese di guerra, 1.340 famiglie hanno subito numerose perdite, con 312 famiglie che hanno perso più di 10 membri.

Visualizza l’immagine a schermo intero

Soldati israeliani si trovano sul lato israeliano del confine tra Israele e Gaza e sorvegliano il territorio palestinese il 30 marzo. Fotografia: Amir Cohen/Reuters

Rispondendo alla pubblicazione delle testimonianze su +972 e Local Call, l’ IDF ha affermato in un comunicato che le sue operazioni sono state effettuate in conformità con le regole di proporzionalità previste dal diritto internazionale. Ha affermato che le bombe stupide sono “armi standard” utilizzate dai piloti dell’IDF in modo da garantire “un alto livello di precisione”.

La dichiarazione descrive Lavender come un database utilizzato “per fare riferimenti incrociati a fonti di intelligence, al fine di produrre livelli aggiornati di informazioni sugli agenti militari delle organizzazioni terroristiche. Non si tratta di un elenco di agenti militari confermati idonei agli attacchi”.

“L’IDF non utilizza un sistema di intelligenza artificiale che identifica gli agenti terroristici o cerca di prevedere se una persona sará un terrorista”, ha aggiunto. “I sistemi informativi sono semplicemente strumenti per gli analisti nel processo di identificazione del target.”

Lavender ha creato un database di decine di migliaia di individui

Nelle precedenti operazioni militari condotte dall’IDF, la produzione di obiettivi umani era spesso un processo ad alta intensità di manodopera. Molteplici fonti che hanno descritto al Guardian lo sviluppo degli obiettivi nelle guerre precedenti, hanno affermato che la decisione di “incriminare” un individuo, o identificarlo come un obiettivo legittimo, sarebbe stata discussa e poi approvata da un consulente legale.

Nelle settimane e nei mesi successivi al 7 ottobre, secondo le fonti, questo modello di approvazione degli attacchi contro obiettivi umani ha subito una drammatica accelerazione. Mentre il bombardamento di Gaza da parte dell’IDF si intensificava, hanno detto, i comandanti richiedevano una serie continua di obiettivi.

“Eravamo costantemente sotto pressione: ‘Portateci più obiettivi’. Ci hanno davvero urlato contro”, ha detto un ufficiale dell’intelligence. “Ci è stato detto: ora dobbiamo mandare all’aria Hamas, a qualunque costo. Bombardiamo tutto quello che possiamo”.

Per soddisfare tali richieste l’IDF è arrivata a fare molto affidamento su Lavender per generare un database di individui che si riteneva avessero le caratteristiche di un PIJ o di un militante di Hamas.

I dettagli sui tipi specifici di dati utilizzati per addestrare l’algoritmo di Lavender, o su come il programma è giunto alle sue conclusioni, non sono inclusi nei resoconti pubblicati da +972 o Local Call. Tuttavia, le fonti affermano che durante le prime settimane di guerra, l’Unità 8200 ha perfezionato l’algoritmo di Lavender e modificato i suoi parametri di ricerca.

Dopo un campionamento casuale e un controllo incrociato delle sue previsioni, l’unità ha concluso che Lavender aveva raggiunto un tasso di precisione del 90%, hanno detto le fonti, portando l’IDF ad approvarne l’uso generalizzato come strumento di raccomandazione degli obiettivi.

Lavender ha creato un database di decine di migliaia di individui che sono stati contrassegnati prevalentemente come membri di basso grado dell’ala militare di Hamas, hanno aggiunto. Questo è stato utilizzato insieme a un altro sistema di supporto decisionale basato sull’intelligenza artificiale, chiamato Gospel , che raccomandava edifici e strutture come obiettivi piuttosto che individui.

Visualizza l’immagine a schermo intero

Due aerei da combattimento F15 dell’aeronautica israeliana vicino alla città di Gedera, nel sud di Israele, il 27 marzo. Fotografia: Abir Sultan/EPA

I resoconti includono testimonianze di prima mano di come gli agenti dell’intelligence hanno lavorato con Lavender e di come la portata della sua rete a strascico potrebbe essere modificata. “Al suo apice, il sistema è riuscito a generare 37.000 persone come potenziali bersagli umani”, ha detto una delle fonti. “Ma i numeri cambiano continuamente, perché dipende da dove si fissa il livello di ciò che è un agente di Hamas”.

E hanno aggiunto: “Ci sono stati momenti in cui la definizione di agente di Hamas era più ampia, e poi la macchina ha cominciato a portarci tutti i tipi di personale della protezione civile, agenti di polizia, sui quali sarebbe un peccato sprecare bombe. Aiutano il governo di Hamas, ma non mettono realmente in pericolo i soldati”.

Prima della guerra, gli Stati Uniti e Israele stimavano che i membri dell’ala militare di Hamas fossero circa 25-30.000.

Nelle settimane successive all’assalto del 7 ottobre condotto da Hamas al sud di Israele, in cui militanti palestinesi hanno ucciso quasi 1.200 israeliani e rapito circa 240 persone, le fonti hanno affermato che c’era stata la decisione di trattare gli uomini palestinesi legati all’ala militare di Hamas come potenziali obiettivi, a prescindere del loro rango o importanza.

Anche i processi di targeting dell’IDF nella fase più intensa del bombardamento sono stati allentati, hanno detto. “C’era una politica completamente permissiva riguardo alle vittime delle operazioni [di bombardamento]”, ha detto una fonte. “Una politica così permissiva che secondo me aveva un elemento di vendetta”.

Un’altra fonte, che ha giustificato l’uso della lavanda per identificare obiettivi di basso rango, ha affermato che “quando si tratta di un militante giovane, non si vuole investire tempo e risorse umane”. Ha affermato che in tempo di guerra non c’è tempo sufficiente per “incriminare attentamente ogni obiettivo”.

“Quindi sei disposto a prenderti il margine di errore derivante dall’uso dell’intelligenza artificiale, rischiando danni collaterali e la morte di civili, e rischiando di attaccare per errore, e convivere con ciò”, hanno aggiunto.

“È molto più facile bombardare la casa di una famiglia”

Le testimonianze pubblicate da +972 e Local Call possono spiegare come un esercito occidentale con capacità così avanzate, con armi in grado di condurre attacchi altamente chirurgici, abbia condotto una guerra con un così vasto tributo di vite umane.

Quando si trattava di prendere di mira i sospetti di basso rango di Hamas e PIJ, hanno detto, la preferenza era attaccare quando si credeva che fossero a casa. “Non eravamo interessati a uccidere gli agenti [di Hamas] solo quando si trovavano in un edificio militare o erano impegnati in un’attività militare”, ha detto uno. “È molto più facile bombardare la casa di una famiglia. Il sistema è costruito per cercarli in queste situazioni”.

Visualizza l’immagine a schermo intero

I parenti fuori dall’obitorio dell’ospedale al-Najjar di Rafah piangono i palestinesi uccisi nei bombardamenti israeliani del 1° febbraio. Fotografia: Mohammed Abed/AFP/Getty Images

Una tale strategia rischiava di aumentare il numero di vittime civili e le fonti affermano che l’IDF ha imposto limiti pre-autorizzati al numero di civili che riteneva accettabile uccidere in un attacco mirato a un singolo militante di Hamas. Si dice che il rapporto sia cambiato nel tempo e variasse a seconda dell’anzianità dell’obiettivo.

Secondo +972 e Local Call, l’IDF ha ritenuto ammissibile uccidere più di 100 civili in attacchi contro funzionari di alto rango di Hamas. “Avevamo calcolato quanti [civili potevano essere uccisi] per il comandante di brigata, quanti [civili] per un comandante di battaglione e così via”, ha detto una fonte.

“C’erano dei regolamenti, ma erano semplicemente molto indulgenti”, ha aggiunto un altro. “Abbiamo ucciso persone con danni collaterali a doppia, se non a tripla cifra. Sono cose che non erano mai accadute prima”. Sembra che ci siano state fluttuazioni significative nella cifra tollerata dai comandanti militari nelle diverse fasi della guerra.

Una fonte ha affermato che il limite delle vittime civili consentite “è andato su e giù” nel corso del tempo, e ad un certo punto è sceso fino a cinque. Durante la prima settimana del conflitto, ha detto la fonte, è stato concesso il permesso di uccidere 15 non combattenti per eliminare i giovani militanti a Gaza. Tuttavia, hanno affermato che le stime delle vittime civili erano imprecise, poiché non era possibile sapere con certezza quante persone si trovassero in un edificio.

Un altro funzionario dei servizi segreti ha affermato che più recentemente nel conflitto il tasso dei danni collaterali consentiti è stato nuovamente abbassato. Ma ad un certo punto della guerra furono autorizzati a uccidere fino a “20 civili non coinvolti” per un singolo agente, indipendentemente dal loro grado, importanza militare o età.

“Non si tratta solo del fatto che si può uccidere chiunque sia un soldato di Hamas, cosa che è chiaramente consentita e legittima in termini di diritto internazionale”, hanno affermato. “Ma ti dicono direttamente: ‘Puoi ucciderli insieme a molti civili.’ … In pratica, il criterio di proporzionalità non esisteva.”

La dichiarazione dell’IDF afferma che le sue procedure “richiedono la conduzione di una valutazione individuale del vantaggio militare previsto e del danno collaterale previsto… L’IDF non effettua attacchi quando il danno collaterale atteso dall’attacco è eccessivo rispetto al vantaggio militare”. Ha aggiunto: “L’IDF respinge apertamente l’affermazione riguardante qualsiasi politica volta a uccidere decine di migliaia di persone nelle loro case”.

Gli esperti di diritto internazionale umanitario che hanno parlato con il Guardian hanno espresso allarme per i resoconti secondo cui l’IDF ha accettato e pre-autorizzato danni collaterali fino a 20 civili, in particolare per i militanti di rango inferiore. Hanno affermato che i militari devono valutare la proporzionalità per ogni singolo attacco.

Visualizza l’immagine a schermo intero

Il fumo si alza sulla Striscia di Gaza, vista dal lato israeliano del confine il 21 gennaio. Fotografia: Amir Levy/Getty Images

Un esperto di diritto internazionale presso il Dipartimento di Stato americano ha affermato di “non aver mai sentito lontanamente parlare di un rapporto di 1 a 15 ritenuto accettabile, soprattutto per i combattenti di livello inferiore. C’è molto margine di azione , ma mi sembra estremo”..

Sarah Harrison, ex avvocato del Dipartimento della Difesa degli Stati Uniti, ora analista del Crisis Group, ha dichiarato: “Mentre ci possono essere alcune occasioni in cui 15 morti collaterali di civili potrebbero essere proporzionate, ci sono altre volte in cui sicuramente non lo sarebbe. Non si può semplicemente fissare un numero tollerabile per una categoria di obiettivi e dire che sarà legalmente proporzionato in ciascun caso”.

Qualunque sia la giustificazione legale o morale della strategia di bombardamento di Israele, alcuni dei suoi ufficiali dell’intelligence sembrano ora mettere in discussione l’approccio adottato dai loro comandanti. “Nessuno ha pensato a cosa fare dopo, quando la guerra sarà finita, o a come sarà possibile vivere a Gaza”, ha detto uno.

Un altro ha affermato che dopo gli attacchi di Hamas del 7 ottobre, l’atmosfera nell’IDF era “dolorosa e vendicativa”. “C’era una dissonanza: da un lato la gente qui era frustrata perché non attaccavamo abbastanza. D’altra parte, alla fine della giornata si vede che sono morti altri mille abitanti di Gaza, la maggior parte dei quali civili”.

FONTE: https://www.lafionda.org/2024/04/04/la-macchina-che-agisce-freddamente/

Commenti recenti