L’accecamento di Sansone (Lovis Corinth, 1911)

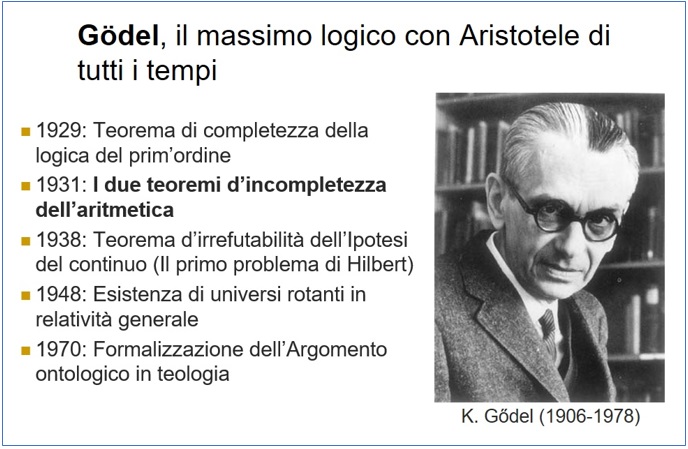

A 40 anni dalla morte del massimo logico matematico di tutti i tempi, esaminiamo una conseguenza del suo teorema d’incompletezza

Un bel giorno ogni studente delle medie impara la procedura per risolvere l’equazione di secondo grado ax^2 + bx + c = 0. I calcoli si svolgono in 9 passi:

- Il quadrato di b, b^2;

- Il quadruplo del prodotto di a per c, 4ac;

- La differenza b^2 – 4ac ≡ ∆;

- La radice quadrata di ∆, √∆;

- La somma algebrica –b + √∆ ≡ y1;

- La somma algebrica –b – √∆ ≡ y2;

- Il doppio di a, 2a;

- Il rapporto tra y1 e 2a dà la prima soluzione: x1 = y1/2a;

- Il rapporto tra y2 e 2a dà la seconda soluzione x2 = y2/2

Chiedo scusa per aver elencato pedissequamente le operazioni (non proprio tutte le istruzioni elementari: per es., la divisione o l’estrazione di radice sono a loro volta successioni di altre operazioni più semplici), ma ciò mi serve ad introdurre il concetto di algoritmo. Ogni sequenza come questa, non importa di quante operazioni (purché in numero limitato, altrimenti la procedura non andrebbe mai a termine) si chiama algoritmo, o software, o programma, che sono tutti sinonimi. Il termine viene da Algoritmus, il nome con cui gli scolastici medievali chiamavano il matematico persiano Al Qhowarismi (IX sec.), il quale per primo aveva trovato la procedura per risolvere quelle equazioni.

Ora, ogni programma informatico, ogni software del mondo, anche il più complesso eseguito dal computer più potente, è null’altro che un algoritmo. Al livello basico, le operazioni eseguibili da una macchina si riducono a 4 istruzioni “meccaniche”: avviarsi, andare avanti oppure indietro di un passo (aggiungere o togliere 1) e arrestarsi. La velocità di calcolo (cioè ad aggiungere o togliere 1) in un personal computer può essere di miliardi di istruzioni al secondo, mentre i grandi calcolatori ne elaborano anche migliaia di miliardi al secondo. I computer quantistici, alla cui comparsa potremmo quest’anno assistere, aumenteranno di altri ordini di grandezza la potenza computazionale, l’affidabilità e la quantità dei dati trattati…, ma le operazioni elementari elaborate saranno sempre le stesse 4: avvio, somma o sottrazione di 1, arresto. Sarà una rivoluzione?

In confronto alla macchina, dai tempi di lady Lovelace la velocità di calcolo della mente umana e la sua precisione appaiono risibili. Se aggiungiamo lo spettacolo quotidiano di guerre, terrore, intolleranze o anche, più mediocremente, di sprechi umani e ambientali, l’intelligenza umana non pare avere grandissimi motivi di orgoglio ed anzi può indurre simpatia per quelle correnti dell’Intelligenza Artificiale (IA) che preconizzano un’era prossima ventura in cui i computer ci surclasseranno anche nelle funzioni superiori della mente, dall’intuizione alla consapevolezza, condividendo ogni nostro elemento di coscienza (felicità, volontà, sensibilità estetica…). Se la mente è prodotta dal cervello e il cervello è un computer, perché i calcolatori di domani non dovrebbero dare origine ad un nuovo tipo di menti? A priori, ci sono 4 risposte possibili:

- (Tesi dell’IA forte) Ogni pensiero è algoritmo e la coscienza è suscitata spontaneamente da algoritmi appropriati.

- (Tesi dell’IA debole) La coscienza è un attributo dell’azione fisica del cervello. Un computer può simulare ogni azione del cervello con un algoritmo corrispondente, ma l’esecuzione algoritmica non può di per sé suscitare la coscienza.

- La coscienza è un attributo dell’azione fisica del cervello, ma questa azione non è computabile (= traducibile in algoritmo).

- (Tesi spiritualista) La coscienza non è un attributo fisico, ma dell’anima. I processi dell’anima non sono computabili, e nemmeno spiegabili scientificamente.

Secondo i fautori della Tesi 1, sarà possibile prima o poi produrre macchine dotate di coscienza: questa facoltà emergerà (ancora la parolina magica, evocata quando non si sa dove attaccare la fisica) appena i programmi saranno sufficientemente complessi, o autoreferenziali, o qualcos’altro. L’universo stesso sarebbe un gigantesco computer, alcune routine (cioè, sottoprogrammi) del quale esplicherebbero quelli stati di coscienza che diciamo appartenerci.

Questa visione lamettriana, da homme machine, ha paradossali assonanze platoniche: se è indipendente dal supporto materiale (biologico, al silicio, alieno, ecc.), il pensiero è solo funzione di strutture d’informazione regolate da leggi matematiche. Il tipo di materia non conta. Nello stesso nostro corpo, con frequenza maggiore che nella nave di Teseo, avviene un continuo ricambio atomico: resta la configurazione immateriale che s’identifica nella coscienza. E tutte le strutture pensanti – biologiche, bioniche o aliene, indipendentemente dai loro hardware intercambiabili – avrebbero gli stessi diritti…

La Tesi 2 considera la coscienza un processo fisico computabile, quindi simulabile da un computer. Ma come la simulazione di una guerra (wargame), per quanto accurata, non è una guerra, così la simulazione del pensiero non darebbe mai consapevolezza alla macchina calcolatrice. La consapevolezza sarebbe una proprietà inscindibilmente connessa alla materia del cervello, in definitiva alle macromolecole al carbonio costituite dai suoi neuroni, alle sinapsi che li collegano e alle trasformazioni fisico-chimiche che vi accadono. Questa visione può sembrarci più dignitosa della Tesi 1, ma non è più allegra: essa preconizza un futuro in cui saremo governati da robot che ci appariranno più intelligenti e più saggi di quanto noi siamo, ma che invece sono ciechi rottami. Un mondo dominato dal look, letteralmente!

Per la Tesi 3, la coscienza sarebbe un fenomeno esclusivamente fisico, ma i suoi processi non sarebbero computabili. A differenza della Tesi 4, secondo cui l’anima è soltanto argomento della metafisica, i fautori della 3 ritengono che la coscienza umana, pur se non riconducibile ad un algoritmo, possa costituire oggetto di analisi scientifica, per esempio delle neuroscienze.

La mia convinzione, argomentata variamente in altri articoli, è che le attività superiori della mente non siano computabili: a supporto, porterò oggi due nuovi argomenti, uno riguardante l’intuizione ed uno ricavato dal Teorema di Gödel (1931). Già uno di essi confuta da solo le tesi 1 e 2 dell’IA. Lascio ai lettori la scelta tra le tesi residue 3 e 4. In entrambi i casi, ringraziando Dio, sarà risparmiata ai nostri discendenti la prospettiva di essere surclassati da automi intelligenti.

Cominciando con l’intuizione, vediamo perché non è simulabile dall’IA ed analizziamo alcune sue applicazioni. L’intuizione è il senso della visione diretta, della comprensione immediata. In quanto tale è l’opposto del software, che è risoluzione indiretta, mediata in n passi, di un problema. L’intuizione risulta per definizione non computabile; e poiché essa è una componente essenziale della mente, l’Intelligenza Artificiale dipendente dal computo non può simulare, né tantomeno suscitare la coscienza.

L’intuizione, il processo prelogico e non algoritmico della mente umana

L’intuizione è usata correntemente, sia nel ragionamento che nella creatività, ed è con la fortuna un motore delle scoperte scientifiche. È usata perfino nelle rigorosissime dimostrazioni matematiche. Prendiamo i primi n numeri dispari. Da un controllo diretto con pochi addendi, risulta che la somma è uguale al quadrato del numero dei termini:

1 = 1^2

1 + 3 = 4 = 2^2

1 + 3 + 5 = 9 = 3^2

1 + 3 + 5 + 7 = 16 = 4^2

…………………………………..

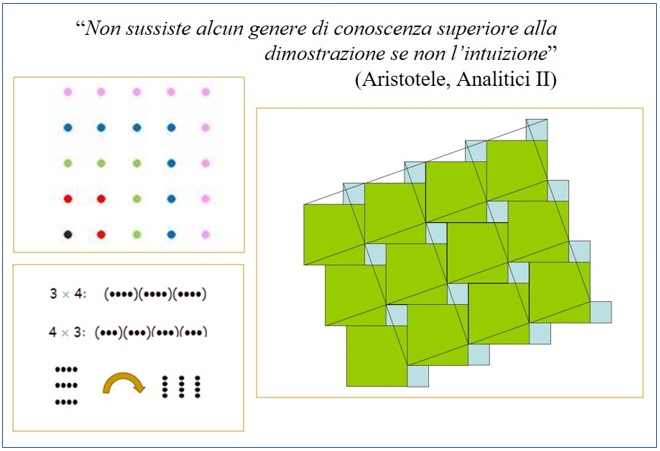

Come sapere se la regola vale per ogni numero degli addendi? Con l’intuizione! V. riquadro in alto, a sinistra, nella Figura: ci basta (immaginare di) disporre un numero dispari di pallini intorno ai dispari precedenti e… “contempliamo” la chiusura del quadrato successivo. Altre due applicazioni matematiche dell’intuizione, rappresentate nella stessa Figura, sono la proprietà commutativa della moltiplicazione e il teorema di Pitagora.

Tutta la storia della matematica conferma che l’intuizione è uno strumento di progresso e di consolidamento della disciplina. La formalizzazione algoritmica, quando c’è, viene dopo. Su ciò, un fautore dell’IA concorderebbe: a denti stretti ammetterebbe che l’intuizione è “forse”, “qualsiasi cosa s’intenda con il termine”, una facoltà creativa; che essa può essere “forse”, “anche” uno strumento utile alla scoperta di nuovi teoremi; ma aggiungerebbe che comunque la validazione di una proposizione che appaia intuitiva va integrata da un algoritmo. È davvero tutto qua?

Certamente i tre teoremi rappresentati in Figura ammettono anche una dimostrazione algoritmica. Ed è anche vero che la massima parte dei teoremi possono essere dimostrati soltanto attraverso una procedura algoritmica, talvolta molto lunga: per esempio, la dimostrazione dell’Ultimo teorema di Fermat che A. Wiles regalò al mondo nel 1994 è stata facilitata dall’ausilio dei calcolatori. Le vere questioni però sono:

-

esistono in matematica questioni indecidibili per via algoritmica?

-

e tra queste ce ne sono di risolubili per via intuitiva?

La domanda 1. si chiama Entscheidungsproblem e fu collocata al secondo posto da Hilbert, al Congresso Internazionale dei Matematici svoltosi a Parigi nel 1900, nella lista dei 23 principali problemi matematici (allora) aperti. La risposta verrà nel 1931 dal Teorema d’incompletezza di Gödel e sarà negativa: esistono problemi indecidibili per via algoritmica. Tra questi, nel 1963, G. Cohen individuerà proprio quello al primo posto nella lista di Hilbert. Per questo risultato, Cohen sarà premiato nel 1966 con la medaglia Fields, una specie di Nobel riservato ai giovani matematici.

Il Teorema di Gödel, presentato da un venticinquenne boemo come tesi di dottorato a Vienna nel giorno in cui un Hilbert ignaro – confidente ancora in una risposta positiva – presentava solennemente (“Noi vogliamo sapere, noi sapremo!”) a Gottinga il suo manifesto di algoritmetizzazione della matematica, fu uno schiaffo al programma formalista onnisciente del matematico tedesco.

Secondo Hilbert, se un sistema matematico contiene proposizioni indecidibili vuol dire che è basato su un insieme incompleto di assiomi e, quindi, in presenza d’indecidibilità di una sua proposizione, basterà integrarla tra gli altri assiomi! Ma il teorema di Gödel nega proprio questa possibilità: ogni sistema formale che abbia la complessità minima dell’aritmetica (ossia di fatto, tutta la matematica: l’algebra, le geometrie euclidea e non, l’analisi, ecc.; nonché tutte le teorie scientifiche) è incorreggibilmente incompleto: esistono al suo interno sempre proposizioni indecidibili. E vano sarebbe l’espediente d’inglobare una proposizione indecidibile tra gli assiomi: questo non farebbe altro che allargare la teoria di altre proposizioni indecidibili… Non è insomma una questione di completezza degli assiomi, né di tempo, né di capacità di memoria, né di velocità elaborativa degli esecutori (umani o digitali o bionici): nessun esecutore potrà mai dimostrare tutte le conseguenze logiche di un set di assiomi coerenti, perché alcune non hanno algoritmo corrispondente.

L’esistenza di congetture, ossia di proposizioni che potrebbero essere vere, ma che non sono (ancora?) dimostrate, è nota da molto tempo. Una famosa è la Congettura di Goldbach (1742), secondo cui ogni numero pari maggiore di 2 è la somma di due numeri primi. Con i moderni calcolatori si è potuto verificarne la veridicità fino a qualche centinaio di miliardi, ma pochi passi in avanti sono stati fatti nella dimostrazione per tutti i numeri pari. Come il problema di Fermat risolto dopo 350 anni di tentativi, anche la Congettura di Goldbach potrebbe un giorno essere decisa; o come il primo problema della lista di Hilbert potrebbe risultare indecidibile; o anche potremmo non sapere mai se sia decidibile o no…

Non posso in un articolo divulgativo come questo riportare la dimostrazione del Teorema di Gödel, che è molto tecnica. Non mi esimerò però da citare una “chicca”, un dono accessorio del teorema d’incalcolabile pregio: la sua dimostrazione svela all’intuizione, nell’ultimo passo, una proposizione vera… indeducibile per via algoritmica! Come la tesi del teorema afferma l’esistenza di proposizioni indecidibili per algoritmo, così la sua procedura dimostrativa si chiude con la contemplazione della verità di una di quelle proposizioni per intuizione. Dunque, esistono proposizioni indecidibili da una macchina, ma decidibili dalla mente.

Il Teorema di Gödel dà un doppio schiaffo alle chimere dell’IA: col primo, sancisce la finitezza del software (e della tecnica) e col secondo supporta il giudizio di superiorità della mente umana sul robot già entro l’ambito della logica.

Commenti recenti